Wir freuen uns sehr, heute eine ganz besondere Erfolgsgeschichte aus unserem Team zu teilen: Unser Kollege Ernesto Curmen wurde für seine herausragende Masterarbeit ausgezeichnet. In seinem Beitrag gibt er uns selbst einen Einblick in die spannenden Inhalte und erzählt, welche Themen ihn dabei besonders bewegt haben. Viel Spaß beim Lesen!

Retrieval Augmented Generation oder auch „RAG“ genannt hat das Panorama der Dokumentsuche für immer verändert. Der wesentliche Ansatz ist ganz simpel: Dokumente werden in kleinere Textabschnitte (Chunks) aufgeteilt, diese sogenannten Chunks werden in Embeddings (Vektorrepräsentationen, die semantische Informationen des Textes enthalten) umgewandelt, die anschließend in einer Datenbank gespeichert werden. Nach diesem Prozess kann ein Nutzer eine Frage stellen, deren Embedding ebenfalls in der Datenbank positioniert werden kann, und somit können alle nächstgelegenen Embeddings abgerufen werden, die semantisch gesehen am ähnlichsten sind. Diese ausgewählten Textabschnitte werden schließlich zur finalen Antwortgenerierung verwendet.

Es besteht jedoch eine zentrale RAG-Problematik: Traditionelle Lösungen ignorieren den gesamten Kontext, was häufig dazu führt, dass das System relevante Informationen nicht in der Wissensdatenbank findet. Beispielsweise formuliert ein hypothetischer Nutzer die folgende Frage an das System: „Welche Entscheidungen wurden bezüglich des weiteren Vorgehens an der Max Mustermann Schule getroffen?“. Dieser Nutzer möchte sich über die Fristen, kommenden Schritte und Vereinbarungen informieren, die im Rahmen des Baus der genannten Schule geplant sind. Dennoch enthält der passende Chunk, in dem sich die Antwort befindet, keine eindeutige Referenz auf die Max Mustermann Schule und kann daher nicht erfolgreich zur Generierung der Antwort abgerufen werden.

In meiner Masterarbeit habe ich mich mit dieser Problematik auseinandergesetzt und habe den Ansatz von „Contextual-Rag“ mit dem Plenarprotokollkorpus aus der Forschungsgruppe DisLab der TU Darmstadt implementiert. Der Schritt der Kontextualisierung findet nach der Aufteilung des Textes in Chunks und vor deren Umwandlung in Embeddings statt. Jeder Chunk wird mit relevantem Kontext angereichert, der aus vorherigen oder nachfolgenden Aussagen stammt oder sogar mit der Hauptidee des gesamten Textes verbunden ist. Dann wird jeder Chunk mit semantischen Anhaltspunkten ergänzt, die vorher nicht explizit vorhanden waren und die nun im Einklang mit der Query eines Nutzers stehen könnten. Diese Kontextualisierung erfolgte mit lokalen Sprachmodellen, die für die Öffentlichkeit zur Verfügung stehen. Aus den Ergebnissen lässt sich schließen, dass die Anwendung von Contextual-RAG für die Suche in einem politischen Korpus eine bis zu 18% bessere Leistung beim Recall erzielt als der Einsatz von Basic-RAG. Das heißt, mit diesem Ansatz werden mehr relevante Treffer unter den Top-k Ergebnissen gefunden:

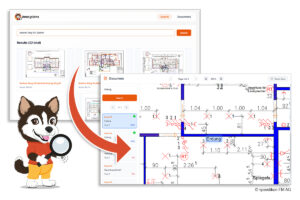

Die in dieser Arbeit gewonnenen Erkenntnisse und entwickelten Methoden werden direkt in die Unternehmenssoftware Inno:docs einfließen. Inno:docs ist ein KI-gestützter Chatbot, der Unternehmensdaten mit natürlicher Sprache durchsuchbar macht und faktenbasierte Antworten liefert. Der Ansatz von Contextual-Rag erlaubt in unserem System mehr relevante Dokumente zu finden, da jeder Chunk den kompletten Kontext des Textes berücksichtigt und nicht isoliert in der Datenbank gespeichert wird.

Bild: Innomatik AG