La precisión es una de las principales razones por las que la inteligencia artificial (IA) falla al reconocer objetos. Esto se debe a que la IA solo reconoce lo que ya conoce. La abstracción y la variación no son sus puntos fuertes. Esta es una de las conclusiones de la tesis de maestría «Interpretando YOLO: Un estudio sobre la explicabilidad en modelos de detección de objetos multiclase» de Gideon Antwi, estudiante en prácticas en innomatik AG. En su tesis, Antwi investiga cómo se produce el reconocimiento de objetos en la inteligencia artificial y qué procedimientos mejoran de manera sostenible la calidad de los resultados.

¿Qué ocurre dentro de una IA? ¿Y cómo se puede arrojar luz sobre la caja negra que representa la IA para la mayoría de las personas? Antwi quiso investigar estas preguntas en su tesis de maestría y eligió el tema del reconocimiento de imágenes. Para su estudio, utilizó unas 10.000 imágenes como conjunto de datos para entrenar el modelo (YOLO), cada una mostrando una variación de 12 objetos diferentes. Los objetos provenían de un conjunto de 81 cartas de juego con diferentes patrones, que también establecieron 81 clases para el reconocimiento y la clasificación de los resultados.

En un primer paso, Antwi dispuso las cartas en una cuadrícula uniforme de cuatro cartas de ancho y tres de largo sobre un fondo oscuro. Posteriormente, se utilizó un fondo claro. Antwi también realizó una prueba sobre una mesa de madera. El investigador también varió la iluminación, así como el orden de las cartas, que más tarde se colocaron parcialmente superpuestas o en diagonal.

«Esencialmente, las variaciones ofrecidas en las imágenes del conjunto de datos deben ser lo más amplias posible para que, en el mejor de los casos, todas las eventualidades ya se tengan en cuenta durante el entrenamiento y la IA funcione de manera fiable en la vida cotidiana», explica Antwi. Esto se debe a que una IA solo puede reconocer exactamente lo que ya conoce. Esto se aplica no solo al objeto en sí, sino también a todos los factores que lo acompañan. A diferencia de los humanos, una IA no puede abstraer a partir de conocimientos básicos, sino que debe aprender cada conocimiento por separado.

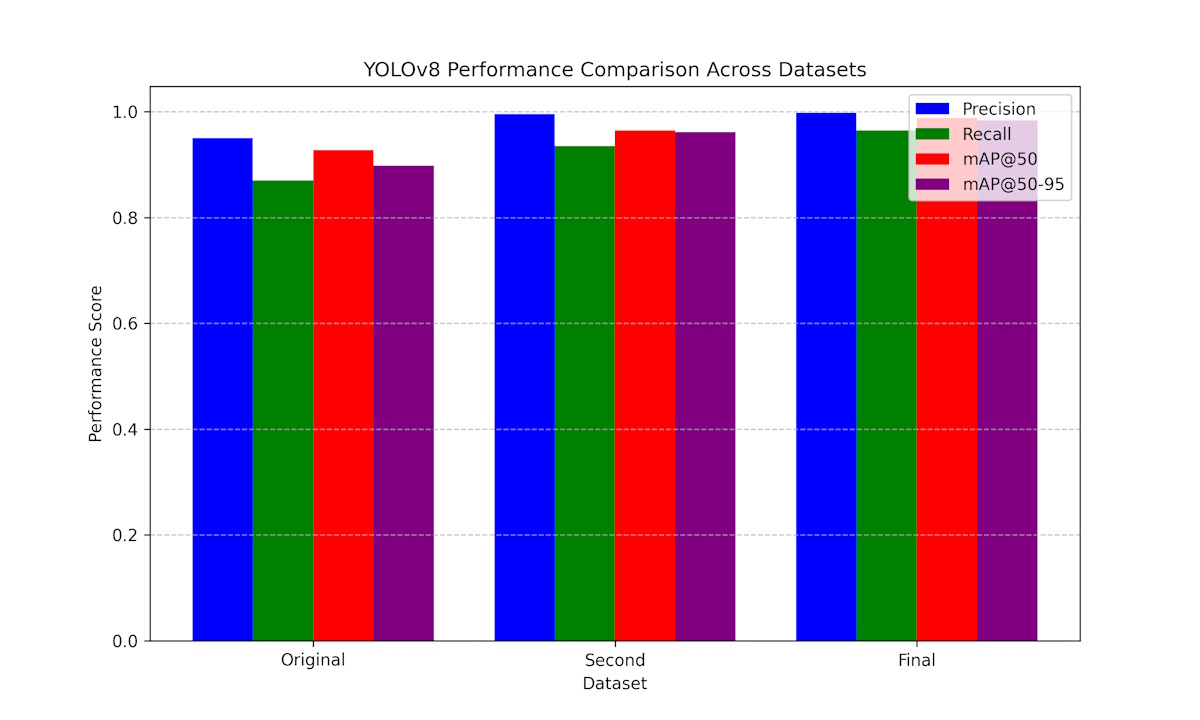

«Básicamente, hay que intentar ponerse en el lugar de la IA y preguntarse qué estoy pensando cuando reconozco el objeto y por qué podría fallar», dice Antwi sobre su enfoque, que mejoró gradualmente el rendimiento del reconocimiento. La clave aquí fue analizar qué objetos no se reconocían y por qué. Las causas incluían reflejos de luz, bajos contrastes, límites apenas visibles entre las cartas individuales o un fondo muy decorado que se reconocía como otra carta. Antwi identificó estas fuentes de error y las reentrenó sistemáticamente para que el algoritmo pudiera eliminarlas.

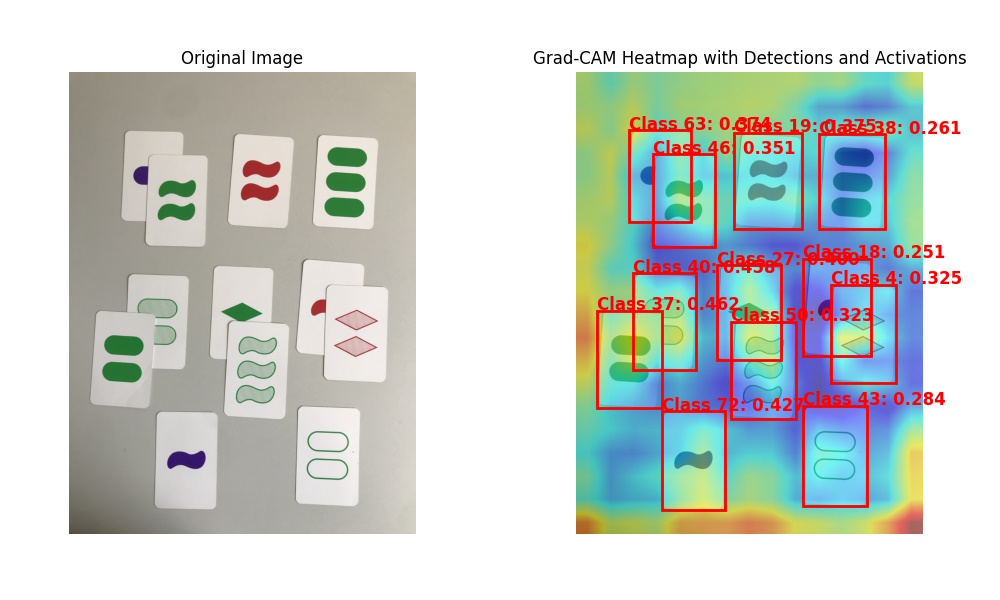

Para comprender exactamente qué reconocía la IA en cada ejecución y dónde había lagunas en su rendimiento de reconocimiento, Antwi utilizó un programa desarrollado por él mismo que mostraba las actividades de la IA en forma de un mapa de calor. Esto mostró que incluso en la misma ejecución de entrenamiento, la IA procesaba imágenes idénticas con una intensidad muy diferente, por ejemplo, solo el área central en una ejecución y toda la imagen en una ejecución posterior.

El estudio demuestra que una IA aprende paso a paso y que cada causa de error debe identificarse y comprenderse para reentrenar sistemáticamente el modelo con contenido adecuado. «Un entrenamiento intensivo es la única manera de garantizar una detección fiable en la práctica», aconseja Antwi como consecuencia de su observación. El tiempo requerido para un análisis detallado de errores y el entrenamiento dirigido de detalles específicos se compensa rápidamente en el uso productivo gracias a la alta calidad de los resultados.

Imagen: innomatik AG/Gideon Antwi